Микроконтроллеры, миниатюрные компьютеры, которые могут выполнять простые команды, являются основой для миллиардов подключенных устройств, от устройств Интернета вещей (IoT) до датчиков в автомобилях. Но дешевые микроконтроллеры с низким энергопотреблением имеют очень ограниченный объем памяти и не имеют операционной системы, что затрудняет обучение моделей ИИ на «высокотехнологичном оборудовании», которое работает независимо от центральных вычислительных ресурсов.

Обучение модели машинного обучения на интеллектуальном периферийном устройстве позволяет ей адаптироваться к новым данным и делать более точные прогнозы. Например, обучение модели на интеллектуальной клавиатуре может позволить клавиатуре постоянно учиться на вводе текста пользователем. Однако процесс обучения требует так много памяти, что обычно выполняется с использованием мощных компьютеров в центре обработки данных, прежде чем модель будет развернута на машине. Это дороже и вызывает проблемы с конфиденциальностью, поскольку пользовательские данные должны отправляться на центральный сервер.

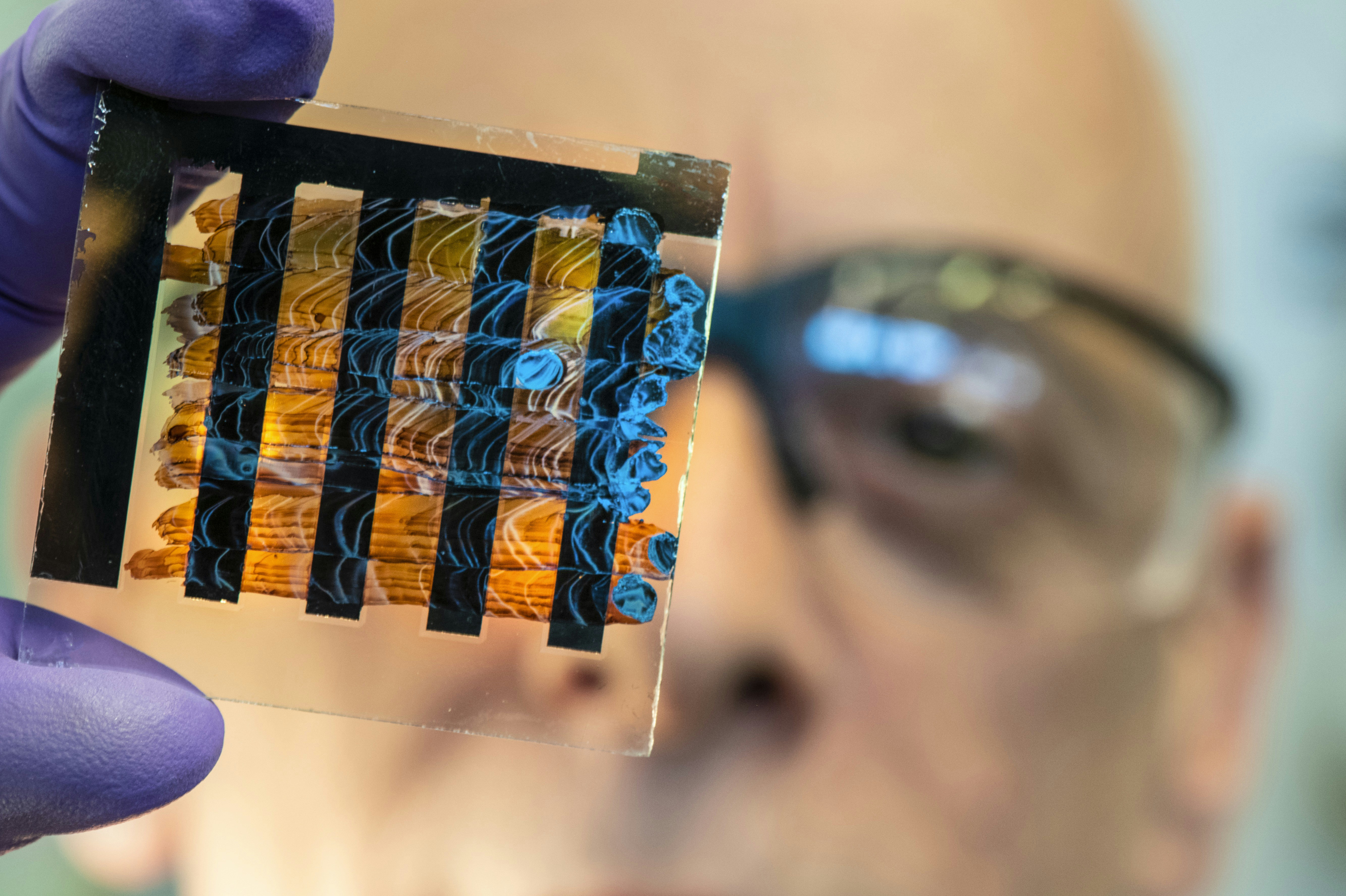

Чтобы решить эту проблему, исследователи из Массачусетского технологического института и Лаборатории искусственного интеллекта Watson AI Lab при MIT-IBM разработали новую технологию, которая позволяет машинному обучению использовать менее четверти мегабайта памяти. Другие обучающие решения, предназначенные для подключенных устройств, могут использовать более 500 МБ памяти, что значительно превышает емкость большинства микроконтроллеров в 256 КБ (в одном мегабайте 1024 КБ).

Умные алгоритмы и структура, разработанные исследователями, сокращают объем вычислений, необходимых для обучения модели, делая процесс более быстрым и эффективным с точки зрения использования памяти. Их метод можно использовать для обучения модели машинного обучения на микроконтроллере за считанные минуты.

Эта технология также поддерживает конфиденциальность, сохраняя данные на устройстве, что может быть особенно полезно, когда данные являются конфиденциальными, например, в медицинских приложениях. Он также может включать настройку формы в зависимости от потребностей пользователей. Более того, фреймворк поддерживает или улучшает точность модели по сравнению с другими методами обучения.

«Наше исследование устройств IoT позволяет не только делать выводы, но и постоянно обновлять модели ИИ для вновь собранных данных, прокладывая путь для непрерывного обучения на устройстве», — говорит Сун Хан, доцент кафедры электротехники и компьютерных наук. (EECS), член Массачусетского технологического института (MIT): -IBM Watson AI Lab и старший автор бумага описание этого нововведения.

К Хану в статье присоединились соавторы и докторанты EECS Цзи Линь и Лигенг Чжу, а также постдокторанты Массачусетского технологического института Вей-Минг Чен и Вей-Чен Ван, а также Чуанг Ган, член ведущей исследовательской группы MIT-IBM. Уотсон Лаборатория искусственного интеллекта. Исследование будет представлено на конференции Neural Information Processing Systems.

Хан и его команда ранее обращались Память и вычислительные узкие места которые существуют при попытке запустить модели машинного обучения на небольших высокопроизводительных машинах, как часть Инициатива TinyML.

тренировка с легким весом

Распространенный тип модели машинного обучения известен как нейронная сеть. Эти модели в общих чертах основаны на человеческом мозге и содержат слои взаимосвязанных ганглиев или нейронов, которые обрабатывают данные для выполнения задачи, например распознавания людей на изображениях. Модель должна быть сначала обучена, что включает в себя показ миллионов примеров, чтобы она могла изучить задачу. По мере обучения модель увеличивает или уменьшает силу связей между нейронами, которые известны как веса.

Модель может подвергаться сотням обновлений по мере обучения, а промежуточные активации должны сохраняться в течение каждого раунда. В нейронной сети активация является промежуточным результатом среднего слоя. Хан объясняет, что могут быть миллионы весов и активаций, для обучения модели требуется гораздо больше памяти, чем для запуска ранее обученной модели.

Хан и его сотрудники использовали два алгоритмических решения, чтобы сделать процесс обучения более эффективным и менее требовательным к памяти. Первый, известный как разреженное обновление, использует алгоритм, определяющий наиболее важные веса, которые необходимо обновлять в каждом тренировочном цикле. Алгоритм начинает замораживать веса один за другим, пока не увидит, что точность упадет до определенного предела, а затем останавливается. Остальные веса обновляются, при этом активации, соответствующие замороженным весам, не нужно хранить в памяти.

«Обновление всей модели очень дорого, потому что активаций много, поэтому люди, как правило, обновляют только последний слой, но, как вы можете себе представить, это снижает точность. Для нашего метода мы выборочно обновляем эти важные веса и следим за тем, чтобы точность постоянно поддерживается. Полная», — говорит Хан.

Их второе решение включает в себя количественное обучение и упрощение весов, которые обычно составляют 32 бита. Алгоритм вращает веса так, чтобы они составляли всего восемь бит, с помощью процесса, известного как квантование, который сокращает объем памяти как для обучения, так и для вывода. Вывод — это процесс применения модели к набору данных и создания прогноза. Затем алгоритм применяет метод, называемый квантовым воспринимаемым масштабированием (QAS), который действует как множитель для корректировки соотношения между весом и градиентом, чтобы избежать падения точности, которое может быть связано с количественным обучением.

Исследователи разработали систему под названием Micro Training Engine, которая может запускать эти алгоритмические инновации на простом микроконтроллере, не имеющем операционной системы. Эта система изменяет порядок шагов в процессе обучения, так что больше работы выполняется на этапе сборки, прежде чем модель будет развернута на периферийном устройстве.

«Мы используем множество арифметических операций, таких как автоматическая дифференциация и оптимизация графов, чтобы собрать время. Мы также агрессивно сокращаем избыточные операторы для поддержки спорадических обновлений. После безотказной работы у нас гораздо меньше нагрузки на устройство», — объясняет Хан.

успешное ускорение

Для его оптимизации требовалось всего 157 КБ памяти для обучения модели машинного обучения на микроконтроллере, в то время как другим технологиям, предназначенным для упрощенного обучения, по-прежнему требовалось от 300 до 600 МБ.

Они протестировали свою структуру, обучив модель компьютерного зрения обнаруживать людей на изображениях. Всего за 10 минут тренировки я научился успешно выполнять задание. Их метод смог обучить модель более чем в 20 раз быстрее, чем другие методы.

Теперь, когда они продемонстрировали успех этих методов для моделей компьютерного зрения, исследователи хотят применить их к языковым моделям и различным типам данных, таким как данные временных рядов. В то же время они хотят использовать то, что они узнали, для масштабирования более крупных моделей без ущерба для точности, что может помочь уменьшить углеродный след обучения крупномасштабных моделей машинного обучения.

«Адаптация/обучение модели ИИ на устройстве, особенно на встроенных контроллерах, является открытой задачей. Это исследование Массачусетского технологического института не только успешно продемонстрировало возможности, но и открыло новые возможности для настройки устройства, обеспечивающего конфиденциальность в режиме реального времени», — сказал он. — говорит Нилеш Джейн, главный инженер Intel, не участвовавший в этой работе. «Нововведения в публикации имеют более широкое применение и запустят совместные исследования для нового системного алгоритма».

«Обучение на устройстве — это следующее крупное достижение, над которым мы работаем в области подключенных интеллектуальных устройств. Группа профессора Сон Хань продемонстрировала значительный прогресс в демонстрации эффективности передового оборудования для обучения», — добавляет Джилли Ху, вице-президент и руководитель Исследования искусственного интеллекта в Qualcomm. «Qualcomm наградила свою команду Innovation Fellowship за дальнейшие инновации и продвижение в этой области».

Эта работа финансируется Национальным научным фондом, MIT-IBM Watson AI Lab, MIT AI Hardware Program, Amazon, Intel, Qualcomm, Ford Motor Company и Google.

«Чрезвычайный решатель проблем. Ниндзя для путешествий. Типичный веб-наркоман. Проводник. Писатель. Читатель. Неизлечимый организатор».

More Stories

Магнитные микрокатушки улучшают таргетную терапию неврологических расстройств

Nexxen запускает решение для телезрителей

CDC сообщает о серьезных достижениях в защите американцев от жары